Besten AI 3D Generatoren Text zu 3D Image zu 3D Video zu 3D

Die Revolution der 3D-Modellierung ist da! Mit AI 3D-Generatoren verwandelst du Worte, Bilder oder Videos in faszinierende dreidimensionale Modelle – kinderleicht und ohne komplizierte CAD-Software. Ob du Prototypen für den 3D-Druck benötigst, digitale Avatare erstellen möchtest oder Gaming-Assets entwickelst: Diese intelligenten Tools öffnen dir eine Welt voller kreativer Möglichkeiten. In diesem umfassenden Ratgeber stellen wir dir die besten AI 3D-Generatoren vor und zeigen dir, wie du sie optimal für deine Projekte einsetzt.

Die Zukunft der 3D-Modellierung beginnt jetzt

Stell dir vor, du beschreibst einfach mit Worten, was du brauchst, und innerhalb von Minuten hast du ein vollständiges 3D-Modell vor dir. Was nach Science-Fiction klingt, ist heute Realität. KI-gestützte 3D-Generatoren haben die Art und Weise revolutioniert, wie wir digitale Objekte erstellen. Egal ob du Designer, Maker, Spieleentwickler oder einfach nur neugierig bist – diese Tools demokratisieren die 3D-Modellierung und machen sie für jeden zugänglich.

Welche Technologien stecken hinter AI 3D-Generatoren?

Bevor wir in die konkreten Tools eintauchen, ist es hilfreich zu verstehen, wie diese KI-Systeme überhaupt funktionieren. Die verschiedenen Grundlagenmodelle nutzen unterschiedliche Ansätze, um aus deinen Eingaben beeindruckende 3D-Modelle zu zaubern.

Generative Adversarial Networks (GANs)

Diese clevere Technologie lässt zwei neuronale Netzwerke gegeneinander antreten: Eines erstellt Modelle, das andere bewertet sie. Durch diesen „Wettbewerb“ entstehen immer realistischere 3D-Objekte mit beeindruckenden Details und authentischen Texturen. GANs sind besonders stark bei fotorealistischen Ergebnissen.

Variational Autoencoders (VAEs)

VAEs arbeiten mit einem sogenannten latenten Raum – einer Art mathematischem Universum möglicher Designs. Sie komprimieren deine Texteingabe in diesen Raum und „entfalten“ sie dann zu einem 3D-Modell. Das Ergebnis: kreative Variationen, die deine Beschreibung auf unterschiedliche Weise interpretieren.

Point Cloud Generators

Diese Generatoren erstellen 3D-Objekte als Wolke aus einzelnen Punkten im Raum – perfekt für technische Anwendungen. Wenn du präzise Messungen oder ingenieurmäßige Genauigkeit benötigst, sind Punktwolken-Generatoren deine erste Wahl.

Deep Convolutional GANs (DCGANs)

Die erweiterte Version der GANs nutzt tiefe neuronale Faltungsnetzwerke für noch höhere Auflösungen. DCGANs sind die Spezialisten für hochdetaillierte, fotorealistische 3D-Modelle und werden häufig in professionellen Produktionsumgebungen eingesetzt.

Transformer-Modelle

Ursprünglich für Sprachverarbeitung entwickelt, verstehen Transformers komplexe Zusammenhänge in deinen Beschreibungen besonders gut. Sie erfassen Kontext und Beziehungen zwischen verschiedenen Objektteilen und erzeugen dadurch semantisch stimmige 3D-Modelle.

AI Text zu 3D Generatoren: Vom Wort zum Objekt

Die faszinierendste Kategorie sind Tools, die aus reinem Text 3D-Modelle erschaffen. Du beschreibst einfach, was du möchtest – die KI übersetzt deine Worte in Geometrie, Texturen und Form. Ideal für schnelle Prototypen und kreative Experimente.

Spline AI: Der Allrounder für Designer

Spline AI hat sich als einer der vielseitigsten Text-zu-3D-Generatoren etabliert und begeistert durch seine intuitive Bedienung. Das Tool versteht natürliche Sprache überraschend gut und setzt deine Beschreibungen in beeindruckende 3D-Objekte um.

Besondere Stärken von Spline AI:

- Schnelle Iterationen: Verfeinere deine Modelle durch einfache Textanpassungen, ohne komplexe 3D-Software bedienen zu müssen

- Export-Optionen: Modelle lassen sich in gängigen Formaten wie OBJ, STL und GLTF exportieren – perfekt für 3D-Druck oder Game Engines

- Browser-basiert: Keine Installation nötig, du arbeitest direkt im Browser mit vollem Funktionsumfang

Masterpiece Studio: Professionelle Assets in Minuten

Als weltweit einer der ersten vollwertigen Text-zu-3D-Generatoren hat Masterpiece Studio den Markt maßgeblich geprägt. Das Tool richtet sich besonders an Game Designer und Content Creator, die schnell hochwertige Assets benötigen.

Die Stärke von Masterpiece Studio liegt in seiner Fähigkeit, spielfertige 3D-Modelle zu erzeugen. Während viele Generatoren nur Rohentwürfe liefern, erstellt Masterpiece Studio Modelle mit sauberer Topologie, UV-Maps und optimierten Polygon-Counts.

Warum Masterpiece Studio besonders für 3D-Druck geeignet ist:

- Wasserdichte Geometrie: Modelle sind standardmäßig manifold und druckbar – keine Reparaturen in Slicing-Software nötig

- Skalierbare Details: Du kannst den Detailgrad an deine Druckauflösung anpassen und so Druckzeit optimieren

- STL-Export: Direkter Export im Standard-3D-Druckformat mit korrekten Einheiten

Meshcapade: Spezialist für menschliche Avatare

Wenn es um die Erstellung realistischer menschlicher 3D-Modelle geht, ist Meshcapade unschlagbar. Die patentierte SMPL-Body-Model-Technologie ermöglicht es, präzise digitale Doppelgänger aus minimalen Eingaben zu erstellen.

Besonders beeindruckend: Meshcapade kann aus einem einzigen Foto einen vollständigen 3D-Avatar erstellen – unabhängig von Pose, Beleuchtung oder Kamerawinkel. Die zugrundeliegende KI wurde mit Millionen von 3D-Körper-Scans trainiert und versteht menschliche Anatomie bis ins kleinste Detail.

Anwendungsbereiche für Meshcapade:

- E-Commerce: Erstelle virtuelle Models für Bekleidungs-Shops, um Kunden eine realistische Passform zu zeigen

- Gaming & VR: Generiere NPCs oder spielbare Charaktere mit realistischer Anatomie

- Medizin & Forschung: Erstelle anatomische Modelle für Lehre und Visualisierung

- 3D-Druck: Drucke personalisierte Figuren oder Prototypen für Ergonomie-Studien

Mochi: Der Game-Development-Assistent

Mochi ist kein eigenständiger Generator, sondern ein intelligentes Plugin, das sich direkt in deine Entwicklungsumgebung integriert. Es versteht Befehle in natürlicher Sprache und setzt sie unmittelbar in deiner 3D-Engine um.

Das Besondere an Mochi ist der Kontext-Bezug: Das Tool versteht nicht nur isolierte Befehle, sondern auch Zusammenhänge in deinem Projekt. Wenn du „erstelle eine Wand passend zur vorhandenen Architektur“ sagst, analysiert Mochi deine bestehende Szene und generiert ein stilistisch passendes Objekt.

Luma AI: Photorealismus auf höchstem Niveau

Luma AI steht für eine neue Generation von 3D-Generatoren, die Photorealismus in den Vordergrund stellen. Die Imagine-Funktion (derzeit in geschlossener Beta) verspricht, die realistischsten KI-generierten 3D-Modelle auf dem Markt zu erzeugen.

Was Luma AI besonders macht, ist die Dual-Funktionalität: Das Tool kann sowohl aus Textbeschreibungen als auch aus Video-Material realistische 3D-Szenen erstellen. Die NeRF-Technologie (Neural Radiance Fields) erfasst dabei nicht nur Geometrie, sondern auch Beleuchtung und Materialeigenschaften.

Innovative Features von Luma AI:

- Video-zu-3D-Konvertierung: Filme ein Objekt mit deinem Smartphone, und Luma erstellt daraus ein vollständiges 3D-Modell mit fotorealistischen Texturen

- Beleuchtungs-Erfassung: Die KI versteht, wie Licht mit Oberflächen interagiert, und erstellt physikalisch korrekte Material-Properties

- Cloud-Rendering: Rechenintensive Prozesse laufen in der Cloud – dein lokaler Rechner wird nicht belastet

- Intuitive App: Die iOS-App macht 3D-Scanning so einfach wie ein Foto zu machen

AI Bild zu 3D Generatoren: Von der Fotografie zur Skulptur

Bild-zu-3D-Generatoren analysieren zweidimensionale Fotos und rekonstruieren daraus dreidimensionale Modelle. Diese Technologie ist besonders wertvoll, wenn du existierende Objekte digitalisieren oder aus Concept Art 3D-Assets erstellen möchtest.

NeROIC: Präzision durch Neural Radiance

NeROIC (derzeit noch nicht öffentlich verfügbar) nutzt fortschrittliche Neural Radiance Field Technologie, um aus einzelnen Bildern oder Bildsequenzen hochpräzise 3D-Rekonstruktionen zu erstellen. Die Technologie geht weit über einfache Tiefenschätzung hinaus.

Das System analysiert nicht nur die sichtbare Geometrie, sondern inferiert auch verdeckte Bereiche: Wenn du ein Foto eines Stuhls von vorne machst, kann NeROIC eine plausible Rückseite generieren, basierend auf seinem Training mit tausenden ähnlichen Objekten.

Potenzielle Anwendungen für NeROIC:

- Produktfotografie: Erstelle 3D-Modelle deiner Produkte für AR-Shopping-Erlebnisse

- Architektur-Dokumentation: Digitalisiere Gebäude und Räume mit einfacher Fotografie

- Kulturerbe-Erhaltung: Erstelle digitale Archive von Kunstwerken und Artefakten

- Reverse Engineering: Rekonstruiere Bauteile für Reparaturen oder Modifikationen

DPT Depth Estimation: Tiefe verstehen, Formen erschaffen

DPT (Dense Prediction Transformer) ist ein zugängliches Open-Source-Tool, das Tiefenkarten aus Einzelbildern erstellt und diese in 3D-Modelle umwandelt. Es ist weniger komplex als NeROIC, dafür aber sofort nutzbar und ideal für Einsteiger.

Die Stärke von DPT liegt in seiner Vielseitigkeit: Es funktioniert mit nahezu jedem Bildmaterial – Fotos, Zeichnungen, Renderings oder Screenshots. Das macht es zum perfekten Experimentier-Werkzeug für kreative Projekte.

| Eigenschaft | Details |

|---|---|

| Input-Format | JPG, PNG, WebP – nahezu alle gängigen Bildformate |

| Output-Format | OBJ, PLY, STL – direkt druckbare 3D-Dateien |

| Verarbeitungszeit | 5-30 Sekunden je nach Bildgröße und Detailgrad |

| Maximale Auflösung | Bis zu 4K-Eingabebilder für hochdetaillierte Modelle |

| Kosten | Kostenlos verfügbar auf Hugging Face Spaces |

Praktische Tipps für beste Ergebnisse mit DPT:

- Beleuchtung: Gleichmäßig beleuchtete Bilder liefern bessere Tiefenschätzungen als Aufnahmen mit starken Schatten

- Kontrast: Hoher Kontrast zwischen Vorder- und Hintergrund verbessert die Trennschärfe

- Perspektive: Frontale Ansichten funktionieren am zuverlässigsten; extreme Winkel können zu Verzerrungen führen

- Nachbearbeitung: Importiere die generierten Modelle in Blender oder Meshmixer für Feintuning und Reparaturen

RODIN: Avatare mit Persönlichkeit

RODIN (entwickelt von Microsoft Research) ist spezialisiert auf die Erstellung digitaler Avatare aus Porträtfotos. Anders als generische Avatar-Generatoren versteht RODIN Gesichtsstrukturen auf anatomischer Ebene und erstellt erstaunlich akkurate digitale Doppelgänger.

Das Besondere: RODIN kombiniert 2D-zu-3D-Konvertierung mit textbasierter Manipulation. Du kannst nicht nur ein Foto hochladen, sondern das resultierende 3D-Modell anschließend durch Textbefehle anpassen: „Mache die Person 20 Jahre älter“ oder „Füge eine Brille hinzu“ funktioniert zuverlässig.

Anwendungsszenarien für RODIN:

- Virtual Reality: Erstelle personalisierte Avatare für soziale VR-Plattformen

- Gaming: Lass Spieler ihre eigenen Gesichter in Charaktere einbringen

- Geschenke & Merchandise: Drucke personalisierte 3D-Figuren oder Büsten

- Film & Animation: Erstelle digitale Doubles für VFX-Arbeit

- Bildung & Training: Generiere diverse Charaktere für Lernumgebungen

AI Video zu 3D Generatoren: Bewegung erfassen und digitalisieren

Video-zu-3D-Technologie (oft als Motion Capture oder Mocap bezeichnet) extrahiert Bewegungsdaten aus Videoaufnahmen und überträgt sie auf 3D-Modelle. Was früher teure spezielle Hardware erforderte, funktioniert heute mit deinem Smartphone.

Move AI: Hollywood-Qualität für jeden zugänglich

Move AI ist die Revolution im Bereich Motion Capture. Statt teurer Marker-Anzüge und spezieller Kamera-Arrays nutzt es Standard-Videoaufnahmen – selbst dein Smartphone reicht aus, um professionelle Bewegungsdaten zu erfassen.

Das System analysiert Videos mithilfe fortschrittlicher Computer Vision und rekonstruiert die dreidimensionalen Bewegungen von Personen oder Objekten. Die Genauigkeit ist dabei vergleichbar mit traditionellen Mocap-Systemen, die ein Vielfaches kosten.

Warum Move AI die Mocap-Branche demokratisiert:

- Kostenfaktor: Erspart Investitionen von 50.000€+ für traditionelle Mocap-Equipment

- Flexibilität: Aufnahmen überall möglich – im Studio, im Freien, in realen Umgebungen

- Geschwindigkeit: Von der Aufnahme zur nutzbaren Animation in Minuten statt Stunden

- Zugänglichkeit: Indie-Entwickler und kleine Studios können jetzt hochwertige Animationen erstellen

Rokoko Vision: Mocap direkt im Browser

Rokoko Vision bringt Motion Capture auf ein neues Level der Zugänglichkeit: Es läuft vollständig im Browser, ohne Installation, ohne Software-Downloads. Einfach Website öffnen, Webcam aktivieren, und schon kannst du deine Bewegungen erfassen.

Das Tool ist besonders clever für Anfänger gestaltet: Ein intuitives Interface führt dich durch den Prozess, und du siehst in Echtzeit, wie deine Bewegungen auf ein 3D-Skelett übertragen werden. Ideal zum Lernen und Experimentieren.

| Aufnahme-Methode | Qualität | Empfohlene Nutzung |

|---|---|---|

| Webcam (720p) | Basis-Qualität | Tests, Prototyping, Bewegungsskizzen |

| Smartphone-Video (1080p) | Gute Qualität | Indie-Projekte, Tutorials, Social Media Content |

| DSLR-Video (4K) | Sehr gute Qualität | Professionelle Animationen, Cinematics |

| Multi-Kamera-Setup | Exzellente Qualität | AAA-Games, Film-VFX, kommerzielle Projekte |

Rokoko Vision Workflow für 3D-Druck-Enthusiasten:

- Schritt 1: Erfasse eine Bewegungssequenz (z.B. deine eigene Pose für eine Figur)

- Schritt 2: Exportiere als FBX und importiere in Blender

- Schritt 3: Übertrage die Pose auf ein druckbares Modell

- Schritt 4: Optimiere für 3D-Druck (Stützstrukturen, Wandstärken)

- Schritt 5: Drucke deine personalisierte Action-Figur in dynamischer Pose

DeepMotion: KI-gestützte Animation-Automatisierung

DeepMotion ist das Schweizer Taschenmesser unter den Mocap-Tools. Entwickelt von Veteranen aus Blizzard, Pixar und Disney, kombiniert es jahrzehntelange Industrie-Erfahrung mit modernster KI-Technologie.

Was DeepMotion besonders auszeichnet, ist die Vollständigkeit der Lösung: Von der Bewegungserfassung über Gesichtsanimation bis zur Hand-Gestik – alles aus einer Hand und perfekt aufeinander abgestimmt.

DeepMotion für professionelle Workflows:

- Batch-Verarbeitung: Verarbeite mehrere Videos gleichzeitig – spart massiv Zeit bei großen Projekten

- Character Retargeting: Übertrage Animationen zwischen völlig verschiedenen Charaktermodellen

- Stil-Transfer: Ändere den Bewegungsstil (z.B. von realistisch zu cartoonartig) mit einem Klick

- Motion Library: Greife auf tausende vorgefertigte Animationen zu oder baue deine eigene Library auf

- API-Zugang: Integriere DeepMotion direkt in deine Pipeline für automatisierte Workflows

So wählst du den richtigen AI 3D-Generator für dein Projekt

Die Vielfalt der verfügbaren Tools kann überwältigend sein. Hier sind konkrete Entscheidungshilfen, basierend auf typischen Anwendungsszenarien:

Für 3D-Druck-Enthusiasten

Empfehlung: Masterpiece Studio oder DPT Depth Estimation

Grund: Beide erzeugen manifold-Geometrie (wasserdichte Modelle ohne Löcher), was essentiell für erfolgreichen 3D-Druck ist. STL-Export ist unkompliziert.

Für Spieleentwickler

Empfehlung: Spline AI + DeepMotion

Grund: Spline für schnelle Asset-Erstellung, DeepMotion für effiziente Character-Animationen. Beide integrieren gut in Unity/Unreal.

Für VR/AR-Entwicklung

Empfehlung: Luma AI + RODIN

Grund: Luma für photorealistische Umgebungen, RODIN für personalisierte Avatare. Beide Output-Formate sind VR-Engine-kompatibel.

Für Architektur-Visualisierung

Empfehlung: Spline AI + DPT

Grund: Textbasierte Erstellung von Gebäude-Komponenten mit Spline, Digitalisierung existierender Strukturen mit DPT für Renovierungsprojekte.

Für E-Commerce

Empfehlung: Meshcapade + Luma AI

Grund: Meshcapade für virtuelle Models und Kleidungs-Fitting, Luma für fotorealistische Produktscans mit AR-Integration.

Für Bildung & Tutorials

Empfehlung: Rokoko Vision (kostenlos)

Grund: Niedrige Einstiegshürde, browserbasiert, ideal zum Lernen und Demonstrieren von 3D-Konzepten ohne Investition.

Optimierung für 3D-Druck: Von der AI-Generierung zur gedruckten Realität

AI-generierte Modelle sind nicht immer sofort druckbar. Hier ist eine Checkliste, um Frustrationen am Drucker zu vermeiden:

3D-Druck-Checkliste für AI-generierte Modelle:

- Manifold-Geometrie prüfen: Nutze Tools wie Meshmixer oder 3D Builder, um Löcher und nicht-manifold Edges zu reparieren

- Wandstärken kontrollieren: Mindestens 1-2mm für FDM, 0.5-1mm für Resin – dünner kann brechen

- Überhänge beachten: Alles über 45° braucht Stützstrukturen – überlege, ob du das Modell anders ausrichten kannst

- Details der Auflösung anpassen: Zu feine Details (unter 0.4mm bei FDM) verschwinden beim Druck – vereinfache wenn nötig

- Skalierung planen: Prüfe kritische Dimensionen wie Schraubenlöcher – AI kennt keine realen Maßstäbe

- Basisplatte sicherstellen: Modelle brauchen eine stabile Kontaktfläche zum Druckbett – notfalls eine Basisplatte hinzufügen

Zukunftsausblick: Was kommt als Nächstes?

Die Entwicklung von AI 3D-Generatoren steht nicht still. Hier sind die spannendsten Trends am Horizont:

Häufige Fallstricke und wie du sie vermeidest

Statt „ein Haus“ schreibe „ein zweistöckiges Einfamilienhaus im modernen Bauhausstil mit Flachdach und großen Fensterfronten“. Spezifität = bessere Ergebnisse.

AI-Generatoren sind fantastisch für Entwürfe und Prototypen, aber nicht jedes Ergebnis ist produktionsreif. Plane Zeit für Nachbearbeitung ein.

Prüfe die Nutzungsbedingungen! Manche Tools erlauben nur persönliche Nutzung, andere auch kommerzielle. Besonders wichtig für verkaufte 3D-Drucke.

AI-generierte Modelle haben oft chaotische Topologie (Polygon-Flow). Für Animationen oder Subdivision-Surfaces ist Retopologie nötig.

Community & Ressourcen: Wo du Hilfe findest

Die AI-3D-Community ist aktiv und hilfsbereit. Hier sind die besten Anlaufstellen:

Kann ich AI-generierte 3D-Modelle kommerziell nutzen und verkaufen?

Das hängt vom jeweiligen Tool und dessen Nutzungsbedingungen ab. Tools wie Spline AI und Masterpiece Studio erlauben in ihren kostenpflichtigen Plänen kommerzielle Nutzung. Bei kostenlosen Versionen ist oft nur persönliche Nutzung gestattet. Prüfe immer die Terms of Service des spezifischen Generators. Für 3D-Drucke, die du verkaufen möchtest, ist eine kommerzielle Lizenz unerlässlich. Einige Plattformen verlangen auch eine Namensnennung oder bieten gegen Gebühr eine erweiterte Lizenz an.

Sind AI-generierte 3D-Modelle sofort druckbar oder brauchen sie Nachbearbeitung?

Die meisten AI-generierten Modelle benötigen zumindest kleine Anpassungen für erfolgreichen 3D-Druck. Häufige Probleme sind nicht-manifold Geometrie (offene Kanten oder Löcher), zu dünne Wandstärken oder problematische Überhänge. Tools wie Masterpiece Studio oder Meshcapade erstellen bereits relativ druckfreundliche Modelle. Für optimale Ergebnisse empfiehlt sich Nachbearbeitung in Software wie Meshmixer, Blender oder speziellen Reparatur-Tools. Besonders wichtig: Prüfe die Wandstärke (mindestens 1-2mm bei FDM), füge wenn nötig Stützstrukturen hinzu und stelle sicher, dass das Modell wasserdicht ist.

Welcher AI 3D-Generator ist am besten für Anfänger geeignet?

Für Einsteiger eignet sich Rokoko Vision hervorragend, da es kostenlos und browserbasiert ist – keine Installation erforderlich. Du kannst sofort mit der Webcam experimentieren und erhältst schnell Ergebnisse. Für Text-zu-3D ist Spline AI sehr anfängerfreundlich dank seiner intuitiven Benutzeroberfläche und verständlichen Anweisungen. Bei Bild-zu-3D ist DPT Depth Estimation ideal für erste Schritte, da es einfach zu bedienen ist und auf Hugging Face kostenlos verfügbar. Alle drei Tools bieten eine niedrige Einstiegshürde und erlauben schnelles Lernen durch Experimentieren.

Wie kann ich die Qualität AI-generierter 3D-Modelle verbessern?

Die Qualität hängt stark von deinem Input ab. Bei Text-zu-3D: Sei sehr spezifisch in deinen Beschreibungen – je mehr Details wie Materialien, Proportionen, Stil und Kontext du angibst, desto besser. Bei Bild-zu-3D: Verwende hochauflösende Fotos mit guter, gleichmäßiger Beleuchtung und klaren Konturen. Multiple Aufnahmen aus verschiedenen Winkeln verbessern das Ergebnis erheblich. Iteriere mehrfach – verfeinere schrittweise statt alles auf einmal perfekt haben zu wollen. Nutze auch die Nachbearbeitung in 3D-Software für Feintuning. Viele Profis kombinieren AI-Generierung für die Basis mit manueller Modellierung für kritische Details.

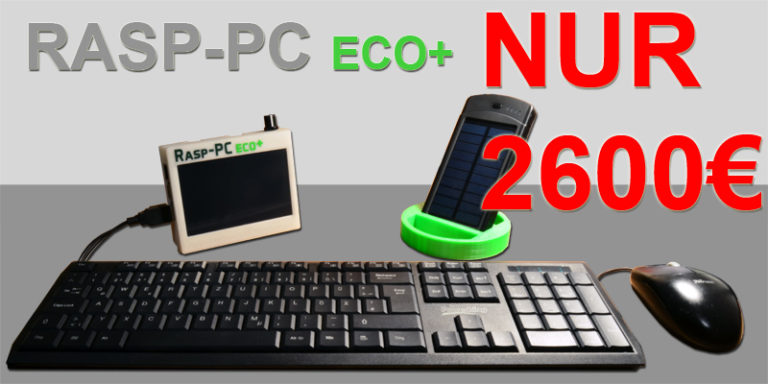

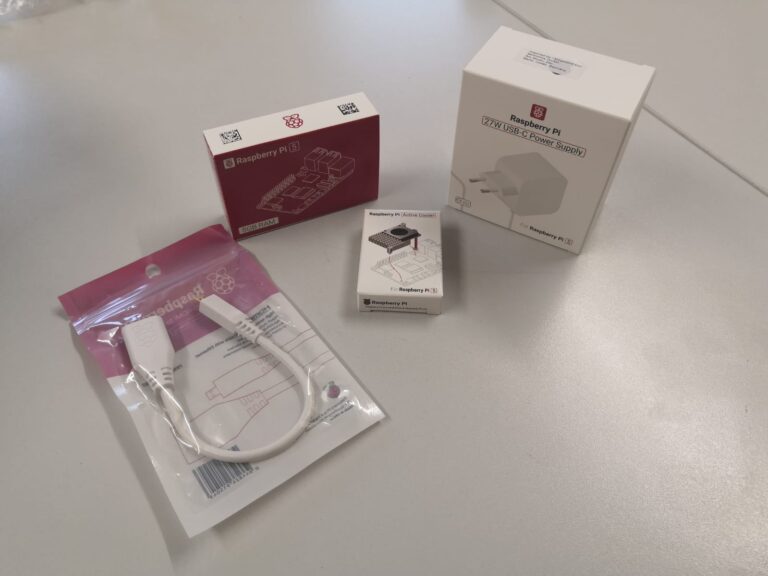

Benötige ich spezielle Hardware für AI 3D-Generatoren?

Die meisten modernen AI 3D-Generatoren laufen cloudbasiert, sodass die Berechnungen auf leistungsstarken Servern stattfinden – dein eigener Computer muss nur den Browser oder die App ausführen. Ein durchschnittlicher Laptop oder Desktop mit stabiler Internetverbindung reicht vollkommen aus. Für Video-zu-3D (Motion Capture) benötigst du lediglich eine Kamera – dein Smartphone genügt für erste Experimente, bessere Ergebnisse erzielst du mit HD-Webcams oder DSLR-Kameras. Lokale Tools wie manche Open-Source-Lösungen profitieren von einer dedizierten Grafikkarte (NVIDIA mit CUDA), aber das ist eher für fortgeschrittene Nutzer relevant. Zusammengefasst: Ein normaler moderner Computer ist völlig ausreichend.